首篇潜空间推理综述!模型思考不必依赖Token,带宽暴增2700+倍

首篇潜空间推理综述!模型思考不必依赖Token,带宽暴增2700+倍大模型在潜空间中推理,带宽能达到普通(显式)思维链(CoT)的2700多倍?

来自主题: AI技术研报

8887 点击 2025-07-16 15:26

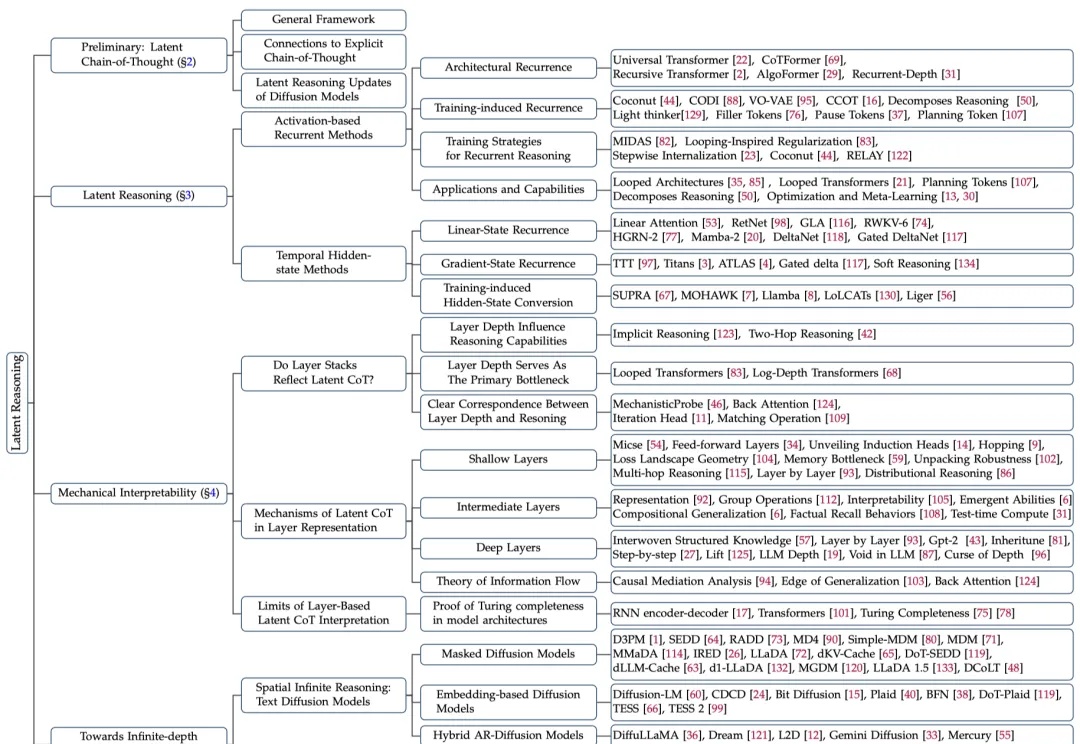

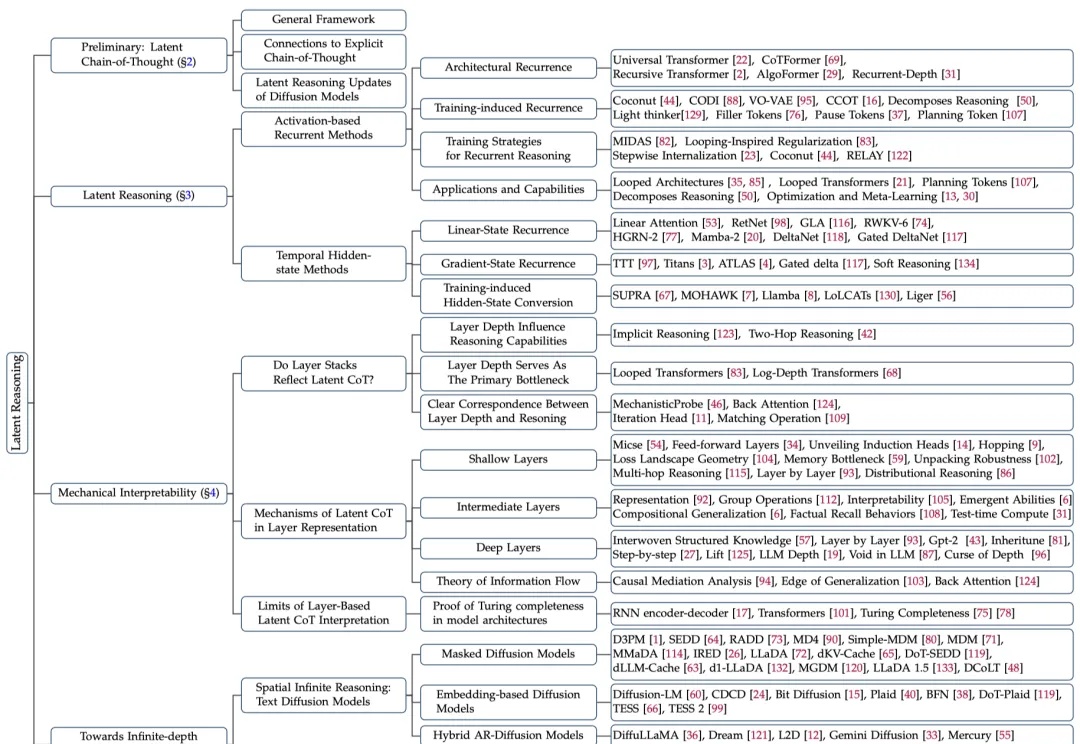

大模型在潜空间中推理,带宽能达到普通(显式)思维链(CoT)的2700多倍?

时隔近70年,那个用来解决最短路径问题的经典算法——Dijkstra,现在有了新突破:被证明具有普遍最优性(Universal Optimality)。

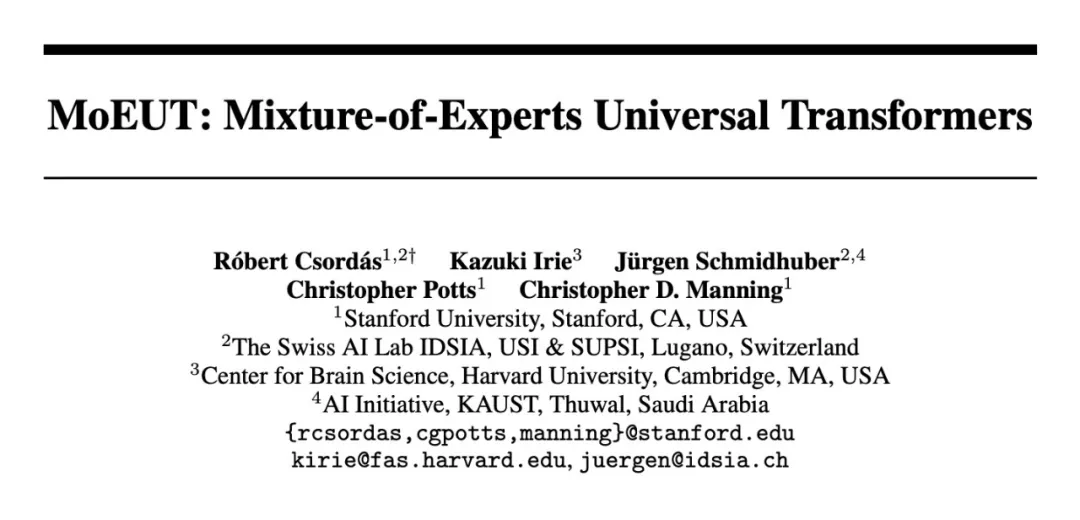

7 年前,谷歌在论文《Attention is All You Need》中提出了 Transformer。就在 Transformer 提出的第二年,谷歌又发布了 Universal Transformer(UT)。它的核心特征是通过跨层共享参数来实现深度循环,从而重新引入了 RNN 具有的循环表达能力。